Wie wir alle wissen, ist Squid ein Caching-Proxy-Server welches die Protokolle wie HTTP, HTTPS, FTP und mehr unterstützt. Mit anderen Worten, Tintenfisch ist als Web-Proxy-Server bekannt, der den ISPs und anderen Organisationen hilft, ihre Bandbreite zu reduzieren, und auch die Antwortzeit erheblich verbessert, da er die häufigsten Inhalte lokal zwischenspeichert. Immer wenn eine neue Anfrage kommt, bedient Squid sie aus seinem Cache, wenn sie zwischengespeichert ist, andernfalls holt sie sie vom Remote-Server und speichert ihren Inhalt im Cache für zukünftige Anfragen.

In diesem Artikel zeigen wir Ihnen, wie Sie Squid (Proxy-Server)-Clustering mit zwei Knoten mit Pacemaker auf einem CentOS 7- oder RHEL 7-System konfigurieren.

Im Folgenden finden Sie meine Labordetails, die ich für diesen Artikel verwendet habe,

- Squid Server 1 (squid01.linuxtechi.lan) – 192.168.1.21 – Mindestens CentOS 7 / RHEL 7

- Squid Server 2 (squid02.linuxtechi.lan) – 192.168.1.22 – Mindestens CentOS 7 / RHEL 7

- Squid-Server-VIP – 192.168.1.20

- Firewall aktiviert

- SELinux aktiviert

Schritt:1) Fügen Sie den Hostnamen in die Datei /etc/hosts ein und wenden Sie alle Updates an

Fügen Sie die folgenden Zeilen in die /etc/hosts-Datei beider Squid-Server ein.

192.168.1.21 squid01.linuxtechi.lan squid01192.168.1.22 squid02.linuxtechi.lan squid02

Installieren Sie alle Updates mit dem folgenden Befehl yum update und starten Sie dann die Knoten neu

[[email protected] ~]# yum update -y &&neu starten[[email protected] ~]# yum update -y &&neu starten

Schritt:2) Installieren Sie Pacemaker- und Fencing-Agentenpakete auf beiden Squid-Servern

Führen Sie den folgenden yum-Befehl auf beiden Servern aus, um die Pakete pacemaker, pcs und fencing zu installieren,

[[email protected] ~]# yum install pcs pacemaker fence-agents-all -y[[email protected] ~]# yum install pcs pacemaker fence-agents-all -y

Sobald die obigen Pakete auf beiden Servern installiert sind, starten und aktivieren Sie den Dienst Pacemaker (pcsd) mit den folgenden Befehlen,

[[email protected] ~]# systemctl start pcsd.service[[email protected] ~]# systemctl enable pcsd.service[[email protected] ~]# systemctl start pcsd.service[[email protected] ~]# systemctl aktiviert pcsd.service

Da in meinem Runden-Setup der Betriebssystem-Firewall-Dienst ausgeführt und aktiviert wird, konfigurieren Sie also die Firewall-Regeln für Hochverfügbarkeit oder Clustering-Dienst, führen Sie das folgende „firewall-cmd ” Befehle auf den Tintenfisch-Servern,

[[email protected] ~]# firewall-cmd --permanent --add-service=high-availabilitysuccess[[email protected] ~]# firewall-cmd --reloadsuccess[[email protected] ~]#[[ email protected] ~]# firewall-cmd --permanent --add-service=high-availabilitysuccess[[email protected] ~]# firewall-cmd --reloadsuccess[[email protected]2 ~]#

Schritt:3) Squid-Server autorisieren und einen Squid-Cluster bilden

Um einen Cluster zu bilden, sollten sich beide Knoten/Server autorisieren, setzen wir zuerst das Passwort von „hacluster ” Benutzer,

[[email protected] ~]# echo "password_here" | passwd --stdin hacluster[[email protected] ~]# echo "password_here" | passwd --stdin hacluster

Verwenden Sie nun die unten stehende „pcs cluster auth ” Befehl von einem der Squid-Server, um beide Server mit Hacluster-Anmeldeinformationen zu autorisieren.

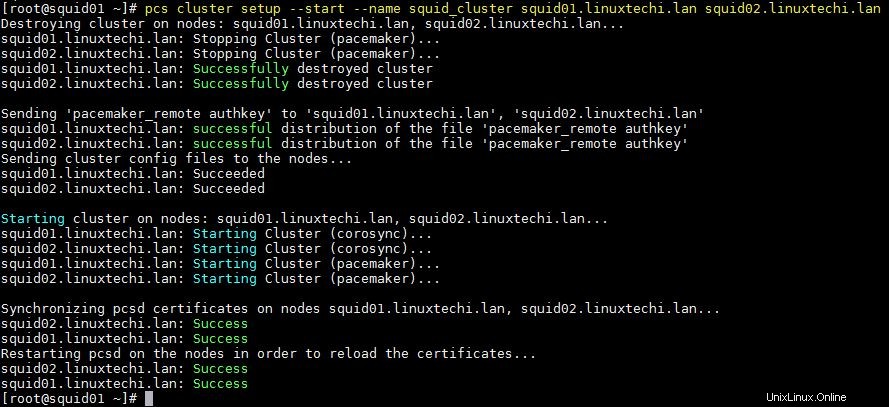

[[email protected] ~]# pcs cluster auth squid01.linuxtechi.lan squid02.linuxtechi.lanUsername:haclusterPassword:squid02.linuxtechi.lan:Authorizedsquid01.linuxtechi.lan:Authorized[[email protected] ~]#Verwenden Sie unten „pcs cluster setup“. “-Befehl von einem der Knoten, um einen Cluster zu bilden, in meinem Fall führe ich ihn von squid01 aus und der Name meines Clusters ist “squid_cluster ”

[[email protected] ~]# pcs cluster setup --start --name squid_cluster squid01.linuxtechi.lan squid02.linuxtechi.lanDie Ausgabe des obigen Befehls sollte in etwa so aussehen:

Aktivieren Sie den pcs-Cluster-Dienst, damit er während des Neustarts automatisch gestartet wird, führen Sie den folgenden Befehl von einem beliebigen Squid-Server aus

[[email protected] ~]# pcs cluster enable --allsquid01.linuxtechi.lan:Cluster aktiviertsquid02.linuxtechi.lan:Cluster aktiviert[[email protected] ~]#Verwenden Sie die folgenden Befehle, um den Clusterstatus zu überprüfen,

[[email protected] ~]# pcs cluster status[[email protected] ~]# pcs statusSchritt:4) Installieren Sie das Squid-Paket auf beiden Servern und deaktivieren Sie das Fencing

Führen Sie den folgenden yum-Befehl auf beiden Servern aus, um Squid (Proxy-Server)-Pakete zu installieren,

[[email protected] ~]# yum install squid -y[[email protected] ~]# yum install squid -yLassen Sie den Squid-Port (3128) in der Betriebssystem-Firewall mit dem folgenden Befehl zu

[[email protected] ~]# firewall-cmd --permanent --add-service=squidsuccess[[email protected] ~]# firewall-cmd --reloadsuccess[[email protected] ~]#[[email protected ] ~]# firewall-cmd --permanent --add-service=squidsuccess[[email protected] ~]# firewall-cmd --reloadsuccess[[email protected] ~]#In meinem Labor habe ich kein Fechtmittel oder Gerät, also deaktiviere ich es mit den folgenden Befehlen,

[[email protected] ~]# pcs property set stonith-enabled=false[[email protected] ~]# pcs property set no-quorum-policy=ignore[[email protected] ~]#Schritt:5) Squid-Cluster-Ressourcen und Cluster-Gruppe konfigurieren

In meinem Lab-Setup habe ich zwei gemeinsam genutzte Festplatten der Größe 1 GB und 12 GB, diese Festplatten sind beiden Servern zugewiesen.

Im Cluster werden wir /etc/squid mounten (d. h. Squid-Konfigurationsdateien) Dateisystem auf einer 1-GB-Festplatte und „/var/spool/squid “ (d. h. Squid-Cache-Verzeichnis) wird auf einer 12-GB-Festplatte gemountet

- /dev/sdb (1 GB Festplatte) – /etc/squid

- /dev/sdc (12-GB-Festplatte) – /var/spool/squid

Da diese Festplatten auf beiden Squid-Servern sichtbar sind, erstellen Sie eine Partition auf /dev/sdb &/dev/sdc mit dem fdisk-Befehl von einem der Squid-Server und formatieren Sie sie dann mit dem xfs-Dateisystem mit dem mkfs.xfs-Befehl

Derzeit befinden sich alle Squid-Konfigurationsdateien im lokalen Ordner /etc/squid. Kopieren Sie die Daten aus dem lokalen Dateisystem /etc/squid auf die freigegebene Festplatte (/dev/sdb1)

[roo[email protected] ~]# mount /dev/sdb1 /mnt/[[email protected] ~]# cp -av /etc/squid/* /mnt/[[email protected] ~]# umount / mnt/

Erstellen Sie nun zwei Dateisystemressourcen, eine für das Dateisystem /etc/squid und eine für /var/spool/squid

Führen Sie das folgende „pcs resource create“ aus “-Befehl von einem beliebigen Squid-Server aus, um eine Dateisystemressource zu erstellen, wobei in meinem Fall der Name der Dateisystemressource „squidfs1“ lautet “ &„squidfs2 “ und Gruppenname als „squidgrp ”

[[email protected] ~]# pcs resource create squidfs1 Filesystem device=/dev/sdb1 directory=/etc/squid fstype=xfs --group squidgrp[[email protected] ~]# pcs resource create squidfs2 Filesystem device=/dev/sdc1 directory=/var/spool/squid fstype=xfs --group squidgrp [[email protected] ~]#

Definieren Sie die Squid-Ressource (systemd service) mit dem Befehl pcs resource und führen Sie den folgenden Befehl von einem der Squid-Server aus

[[email protected] ~]# pcs resource create proxy systemd:squid op monitor interval=10s --group squidgrp[[email protected] ~]#

Definieren Sie Squid vip für Ihren Cluster, in meinem Fall verwende ich „192.168.1.20 ” als squid vip , wird diese IP zwischen diesen Servern schweben, Endbenutzer oder Squid-Clients verwenden diese IP als Squid-Proxy-Server-IP, während sie ihre Proxy-Einstellungen konfigurieren, und verwenden auch den Standard-Squid-Port 3128.

[[email protected] ~]# pcs resource create squid_vip ocf:heartbeat:IPaddr2 ip=192.168.1.20 cidr_netmask=24 op monitor interval=30s --group squidgrp[[email protected] ~]#

Überprüfen Sie nun, ob alle Cluster-Ressourcen gestartet sind oder nicht. Führen Sie „pcs status“ aus ” Befehl von einem beliebigen Squid-Server

[[email protected] ~]# pcs statusCluster-Name:squid_clusterStack:corosyncAktueller DC:squid01.linuxtechi.lan (Version 1.1.19-8.el7_6.4-c3c624ea3d) - Partition mit QuorumLetzte Aktualisierung:Mittwoch, 27. März 06:59:59 2019Letzte Änderung:Mittwoch, 27. März 06:59:02 2019 von root über cibadmin auf squid01.linuxtechi.lan2 Knoten konfiguriert4 Ressourcen konfiguriertOnline:[ squid01.linuxtechi.lan squid02.linuxtechi.lan ]Vollständige Liste der Ressourcen: Ressourcengruppe:squidgrp squidfs1 (ocf::heartbeat:Filesystem): Gestartet squid01.linuxtechi.lan squidfs2 (ocf::heartbeat:Filesystem): Gestartet squid01.linuxtechi.lan proxy (systemd:squid): Gestartet squid01 (ocf::heartbeat:Filesystem): :heartbeat:IPaddr2): Gestartet squid01.linuxtechi.lanDaemon Status: corosync:active/enabled pacemaker:active/enabled pcsd:active/enabled[[email protected] ~]#

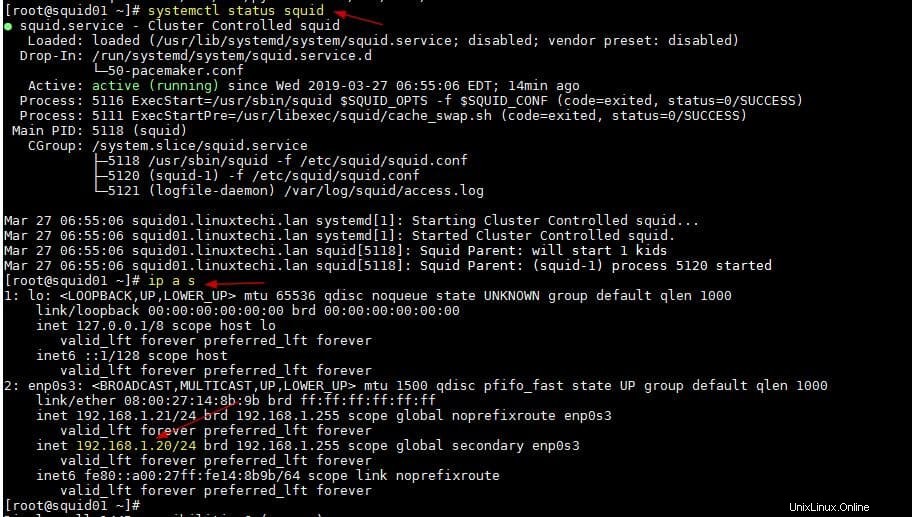

Wie wir oben sehen können, werden alle Ressourcen auf dem Server squid01 gestartet. Lassen Sie uns den Status des Squid-Dienstes und die Squid-VIP überprüfen

[[email protected] ~]# systemctl status squid[[email protected] ~]# ip a s

Die Ausgabe der beiden obigen Befehle sollte in etwa so aussehen:

Das war alles aus diesem Artikel, jetzt können Sie die ACLs, die zu Ihrer Umgebung passen, in der Datei /etc/squid.conf konfigurieren. Bitte teilen Sie uns Ihr Feedback und Ihre Kommentare mit.