Hier ist der Zeitplan der tuned-adm-Konfigurationen...

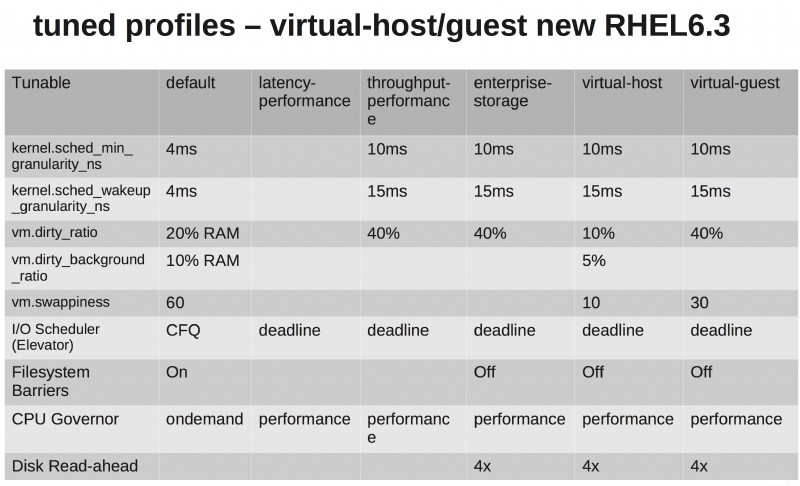

Ich denke, es hilft, sie in tabellarischer Form zu sehen. Die Hauptsache ist, dass die RHEL6-Standardeinstellungen scheiße sind!! Die andere Sache ist, dass die Enterprise-Storage- und Virtual-Guest-Profile identisch sind, abgesehen von der reduzierten Austauschfähigkeit auf der Seite des virtuellen Gastes (macht Sinn, oder?).

Was eine Empfehlung zum Speicher-E/A-Aufzug anbelangt, haben Sie einige Abstraktionsebenen auf der Speicherebene. Die Verwendung des Noop-Schedulers wäre sinnvoll, wenn Sie RDMs verwenden oder Ihren virtuellen Maschinen Speicher direkt präsentieren würden. Aber da sie auf NFS oder VMFS laufen werden, mag ich immer noch die zusätzlichen Tuning-Optionen, die der Deadline-Scheduler bietet.

Abgestimmte Profile können auf laufenden Systemen on-the-fly geändert werden. Wenn Sie also Bedenken haben, testen Sie mit Ihrer Anwendung und spezifischen Umgebung und Benchmark.

Sehen Sie sich Shaks und Larrys Performance-Tuning-Videos von Summit an, sie sprechen ausführlich über die abgestimmten Profile.

- Teil 1 – http://www.youtube.com/watch?v=fATEiBJ3pKw

- Teil 2 – http://www.youtube.com/watch?v=km-vLELmWLs

Einer der größten beabsichtigten Erkenntnisse ist, dass die Profile nur ein empfohlener Ausgangspunkt sind, keine unveränderlichen Zahlen, die für jede Umgebung magisch perfekt sind.

Beginnen Sie mit einem Profil und spielen Sie mit den Einstellungen herum. Generieren Sie einen guten produktionsähnlichen Test-Workload und messen Sie Metriken, die für Ihr Unternehmen wichtig sind.

Ändern Sie eine Sache nach der anderen und zeichnen Sie jedes Ergebnis bei jeder Iteration auf. Wenn Sie fertig sind, überprüfen Sie die Ergebnisse und wählen Sie die Einstellungen aus, die die besten Ergebnisse erzielt haben. Das ist Ihr ideal abgestimmtes Profil.

Die kurze Antwort ist, dass jede Abstimmung Vermutungen ist und nur dann einen Wert hat, wenn sie mit empirischen Daten untermauert ist:Probieren Sie es aus. Messe Es. Wenn es Ihnen nicht gefällt, optimieren Sie es.

Eine längere Antwort:

Eine Erhöhung des dirty_ratio würde wahrscheinlich eine höhere Schreibleistung bedeuten ...IO wird erheblich länger blockiert

Nein. Eine Erhöhung der Dirty Ratio bedeutet, dass Ihr System weniger wahrscheinlich in einen Zustand gerät, in dem es mit dem Blockieren von Schreibvorgängen beginnen muss. Der Nachteil ist, dass mehr Speicher verwendet wird und ein größeres Risiko von Datenverlusten bei einem Ausfall besteht.

was bedeutet, dass laufende Aufgaben mehr Zeit bekommen, ihre Arbeit zu erledigen

Prozesse geben normalerweise nach, bevor ihre Zeitscheibe abläuft. Das Problem mit einer VM besteht darin, dass Ihr Computer möglicherweise mit anderen VMs um CPU und L1/L2-Cache konkurriert – ein hohes Maß an Task-Wechsel (aufgrund von Preempting) hat einen großen Einfluss auf den Durchsatz. Die Art von Anwendungen, die normalerweise in VMs bereitgestellt werden, sind CPU-gebunden (Webserver, Anwendungsserver).

Ja, die Erhöhung des Durchsatzes (die für alle Arten von Anwendungen gilt) geht mit einer Erhöhung der Latenz einher – letztere liegt jedoch in der Größenordnung von Mikrosekunden, wenn die meisten Transaktionen Millisekunden dauern. Wenn Sie Echtzeitfähigkeit/sehr geringe Latenz benötigen, sollten Sie keine VM verwenden.