In diesem Tutorial zeigen wir Ihnen, wie Sie Apache Spark auf Ubuntu 18.04 LTS installieren. Für diejenigen unter Ihnen, die es nicht wussten, Apache Spark ist ein schnelles und universelles Cluster-Computing-System . Es bietet High-Level-APIs in Java, Scala und Python sowie eine optimierte Engine, die Gesamtausführungsdiagramme unterstützt. Es unterstützt auch eine Vielzahl von High-Level-Tools, darunter Spark SQL für SQL und strukturierte Informationsverarbeitung, MLlib für Maschinen Learning, GraphX für die Grafikverarbeitung und Spark Streaming.

Dieser Artikel geht davon aus, dass Sie zumindest über Grundkenntnisse in Linux verfügen, wissen, wie man die Shell verwendet, und vor allem, dass Sie Ihre Website auf Ihrem eigenen VPS hosten. Die Installation ist recht einfach und setzt Sie voraus im Root-Konto ausgeführt werden, wenn nicht, müssen Sie möglicherweise 'sudo hinzufügen ‘ zu den Befehlen, um Root-Rechte zu erhalten. Ich zeige Ihnen Schritt für Schritt die Installation von Apache Spark auf einem 18.04 LTS (Bionic Beaver) Server.

Installieren Sie Apache Spark auf Ubuntu 18.04 LTS Bionic Beaver

Schritt 1. Stellen Sie zunächst sicher, dass alle Ihre Systempakete auf dem neuesten Stand sind, indem Sie die folgenden apt-get-Befehle im Terminal ausführen.

sudo apt-get update sudo apt-get upgrade

Schritt 2. Java installieren.

Apache Spark erfordert die Installation von Java auf Ihrem Server. Standardmäßig ist Java nicht im Ubuntu-Repository verfügbar. Fügen Sie das Oracle Java PPA mit dem folgenden Befehl zu Apt hinzu:

add-apt-repository ppa:webupd8team/java apt-get update -y apt-get install oracle-java8-installer

Überprüfen Sie die Java-Version, indem Sie den folgenden Befehl ausführen:

java -version

Schritt 3. Installieren von Apache Spark auf Ubuntu 18.04 LTS.

Installieren Sie Apache Spark mit dem folgenden Befehl:

wget https://www.apache.org/dyn/closer.lua/spark/spark-2.3.1/spark-2.3.1-bin-hadoop2.7.tgz tar xvzf spark-2.3.1-bin-hadoop2.7.tgz ln -s spark-2.3.1-bin-hadoop2.7 spark

Spark zum Pfad hinzufügen:

nano ~/.bashrc

Fügen Sie als Nächstes diese Zeilen am Ende der .bashrc-Datei hinzu, damit der Pfad den Pfad der ausführbaren Spark-Datei enthalten kann:

SPARK_HOME=/idr00t/spark export PATH=$SPARK_HOME/bin:$PATH

Um diese Änderungen zu aktivieren, führen Sie den folgenden Befehl für die bashrc-Datei aus:

source ~/.bashrc

Spark Shell starten:

./spark/bin/spark-shell

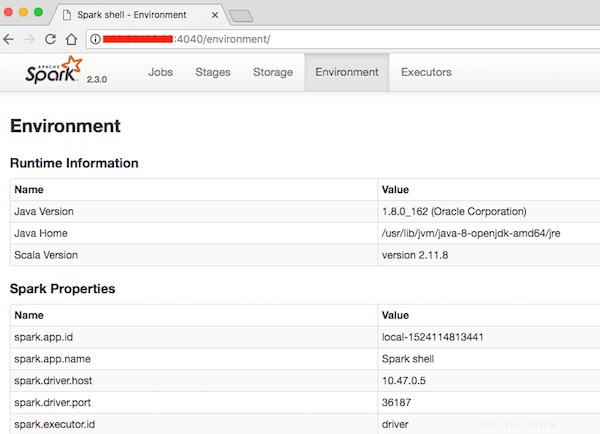

Schritt 4. Zugriff auf Apache Spark.

Apache Spark ist standardmäßig auf HTTP-Port 4040 verfügbar. Öffnen Sie Ihren bevorzugten Browser und navigieren Sie zu http://your-domain.com:4040 oder http://server-ip:40404 und führen Sie die erforderlichen Schritte aus, um die Installation abzuschließen.

Herzlichen Glückwunsch! Sie haben Apache Spark erfolgreich installiert. Vielen Dank, dass Sie dieses Tutorial zur Installation von Apache Spark auf einem Ubuntu 18.04 LTS (Bionic Beaver)-System verwendet haben. Für zusätzliche Hilfe oder nützliche Informationen empfehlen wir Ihnen, dies zu überprüfen die offizielle Apache Spark-Website.